近日,阿里巴巴推出了其最新的大模型Qwen 3,标志着中国开源生态中DeepSeek与Qwen这对“双子星”组合的正式崛起,逐渐取代了以往以Llama为主、Mistral为辅的开源格局。随着Qwen 3的发布,Founder Park邀请了多家AI创业公司的代表,就开源与闭源的选择、模型微调、能力瓶颈及创业中的陷阱等话题进行了深入探讨。其中,心言集团的开源布道师及高级算法工程师“左右”分享了公司在开源生态下的实践经验和技术见解。

“左右”指出,从心言集团的业务角度出发,绝大多数(可能超过90%)的模型需求都需经过本地化微调后部署使用。对于特定任务,如数据构造、数据蒸馏或需要利用GPT、豆包、Qwen等特定大模型的能力时,则会直接调用其API。本地部署的模型主要基于Qwen,根据业务入口的不同,选用不同规模的版本,如7B、32B和72B等。针对具身智能业务,考虑到用户隐私和多模态处理需求,会采用更小规模的多模态模型,如0.5B和1.5B。

选择Qwen模型的原因包括其生态系统的成熟度和稳定性、技术能力与业务的契合度、模型系列的完整性以及开源的持续性和可信赖度。Qwen在中文支持上表现出色,且预训练数据中包含了泛心理和情感陪伴相关内容,这使得基于Qwen的微调模型更易满足心言集团的业务需求。同时,Qwen提供了从0.5B到72B的完整尺寸系列,降低了在不同模型间进行微调和测试的成本。

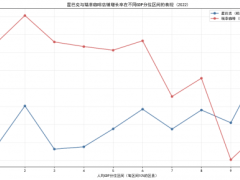

在具身智能和线上互联网业务方面,心言集团面临了不同的挑战。具身智能业务中,主要挑战在于推理成本和生态适配。由于隐私需求,模型需本地部署,但端侧推理卡成本高且推理速度可能不足。若采用国产算力芯片降低成本,则面临生态不完善的问题,适配周期长且成本高。线上互联网业务中,主要挑战在于模型能力和推理成本/延迟。情感陪伴业务对情感细粒度理解要求高,需要模型准确捕捉用户复杂的情感状态,同时,随着用户量和AI使用量的快速增长,推理成本压力大。

“左右”表示,尽管大多数模型厂商在预训练或后训练阶段不会特别关注情感、情绪化的泛心理应用场景数据,但心言集团仍坚持进行后训练,以提升模型在这一领域的表现。他们对基础模型的要求主要是通用能力,而非特定领域能力。如果基础模型的通用能力足够好,后训练时就能更容易地将其拟合到所需方向。同时,他们也意识到,针对特定领域进行后训练可能会损害模型的其他通用能力,因此需在可接受范围内控制这种损害。

对于当前开源模型的发展,“左右”表示期待开源模型能尽可能追平闭源顶尖模型,并希望它们能释放更多的技术细节。他认为,DeepSeek在MoE、原生多模态、代码等方面探索较前沿,而Qwen和Llama更注重社区和通用性,技术选型上相对稳健。这种差异化定位在开源社区中是正常的。

在谈及大模型创业中的陷阱时,“左右”指出,模型与产品的适配度以及对AI在产品中角色的理解是关键问题。他认为,AI更多是后端能力,是处理信息的工具,而不是直接交付结果的前端界面。很多开发者追求简单的“端到端”解决方案,认为大模型能简化一切,但在很多领域,尤其是情感领域,原本需要复杂处理的环节依然需要,甚至可以借助AI做得更精细。直接用AI替代这些环节,可能导致产品缺乏深度和个性化。

“左右”强调,正确的模式应该是“X+AI”,而不是“AI+X”。核心是挖掘和理解用户需求(X),然后思考如何用AI更好地解决这个需求。他提出,用户留存是一个重要的观察指标,很多AI产品留存差,往往意味着产品没有抓住用户的真实痛点,个性化做得不够好。因此,心言集团将继续聚焦泛心理发展的AI化与具身化,以开源为舟,以创新为帆,不断探索情感计算领域的未知。