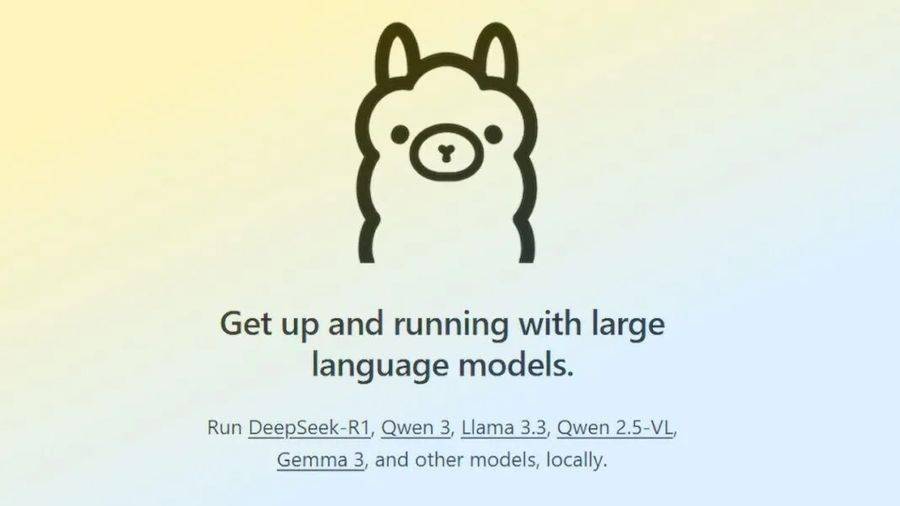

近期,科技领域迎来了一项新的技术突破。据WinBuzzer于5月16日报道,开源大语言模型服务工具Ollama宣布成功研发出一款多模态AI定制引擎,这一创新成果标志着Ollama在技术上实现了对llama.cpp框架的直接依赖的摆脱。

此前,llama.cpp项目通过整合libmtmd库,为项目增添了全面的视觉支持功能。这一进展引发了社区对Ollama与llama.cpp之间关系的广泛讨论。针对这一话题,Ollama团队成员在Hacker News平台上进行了澄清,强调他们的引擎是基于golang独立开发的,并未直接借鉴llama.cpp的C++实现,并对社区的反馈表示了感谢。

在官方声明中,Ollama指出,随着各大科技公司如meta的Llama 4、Google的Gemma 3、阿里巴巴的Qwen 2.5 VL以及Mistral Small 3.1等推出的AI模型复杂性日益增加,现有的技术架构已难以满足高效处理的需求。因此,Ollama决定推出这款全新的多模态AI定制引擎。

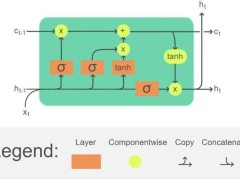

这款新引擎在本地推理精度上实现了显著突破,特别是在处理大型图像并生成大量token时,表现尤为突出。Ollama通过引入图像处理附加元数据,优化了批量处理和位置数据管理,有效避免了图像分割错误导致的输出质量下降问题。他们还采用了KVCache优化技术,进一步加速了transformer模型的推理速度。

在内存管理方面,新引擎也进行了大幅优化,并新增了图像缓存功能。这一功能确保了图像处理后的数据可以重复使用,避免了数据的提前丢弃,从而提高了资源利用效率。为了进一步提升性能,Ollama还与NVIDIA、AMD、Qualcomm、Intel和Microsoft等硬件巨头展开合作,通过精准检测硬件元数据,对内存估算进行了优化。

针对像meta的Llama 4 Scout(一款拥有1090亿参数的混合专家模型MoE)这样的复杂模型,Ollama的新引擎还支持分块注意力(chunked attention)和2D旋转嵌入(2D rotary embedding)等先进技术。这些技术的引入,使得Ollama在处理复杂模型时能够展现出更高的效率和准确性。