在科技界的一次重大突破中,OpenAI于近日揭晓了其最新的推理模型——o3与o4-mini。据官方宣称,这两款模型代表了OpenAI至今为止最为智能的成就,重新定义了智能性与实用性的标准。

o3,作为OpenAI的旗舰推理模型,其能力跨越数学、编程、科学以及视觉感知等多个领域,远超其前身o1及o3-mini。OpenAI指出,o3擅长处理那些需要深度分析与综合考量,答案并不显而易见的复杂问题。而o4-mini,则是一款旨在提供高效快速推理服务的小型优化版模型。

在o3的研发历程中,OpenAI发现大规模强化学习与GPT系列预训练遵循相同的规律:计算量增加,性能随之提升。因此,OpenAI在训练计算量与推理思维方面实现了质的飞跃,显著提高了模型性能。通过强化学习,OpenAI还成功训练了两个新模型使用工具。

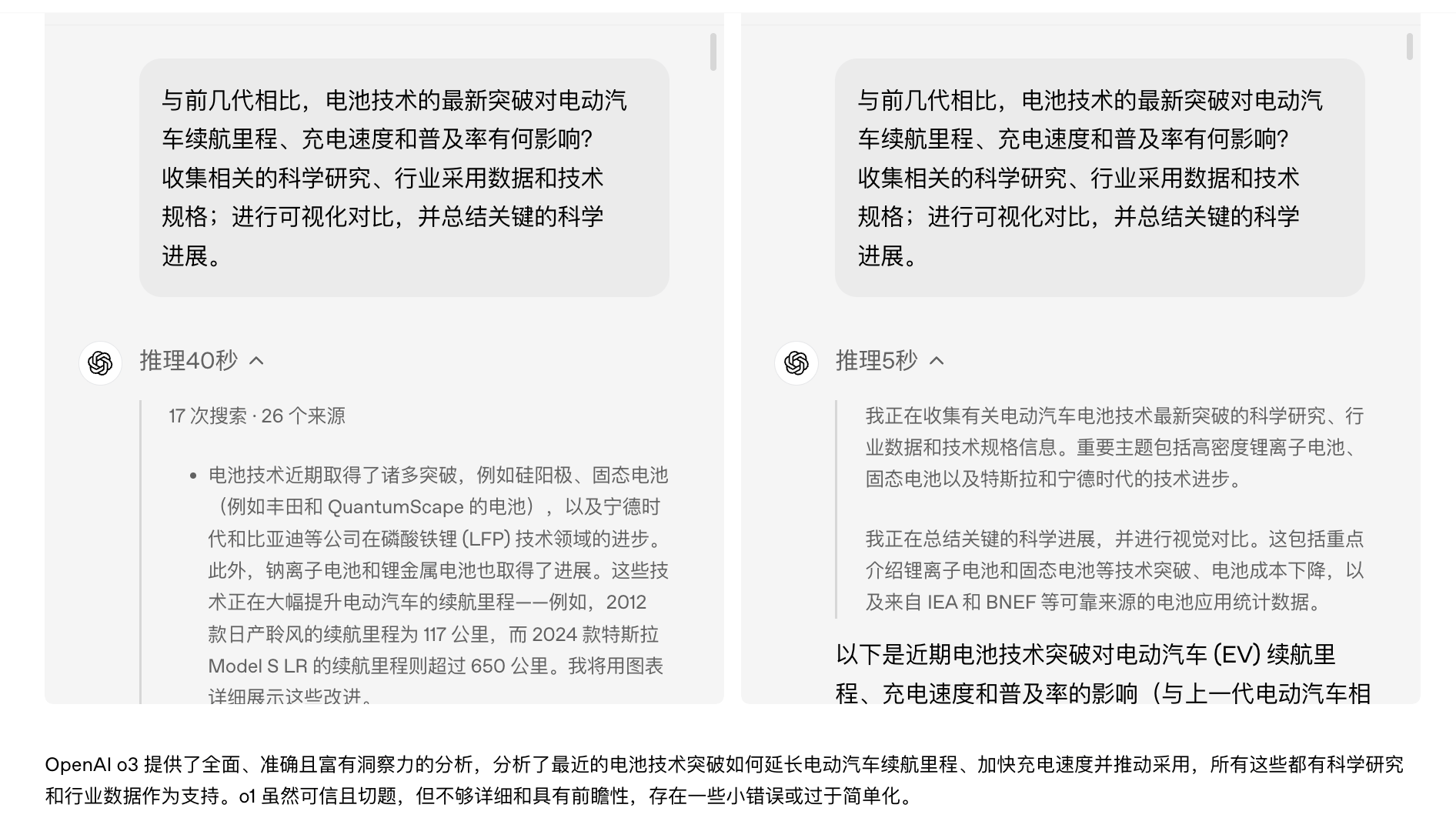

值得注意的是,o3与o4-mini不仅继承了ChatGPT中的所有工具,如网页搜索、图像生成及Python数据分析等,还展现出了更为强大的能力。例如,在回答关于电池技术革新对电动汽车影响的问题时,o1模型在5秒内给出以文字与代码为主的答复,而o3模型则在40秒内,通过多次搜索,不仅提供了文字信息,还直接生成了图像与图表。

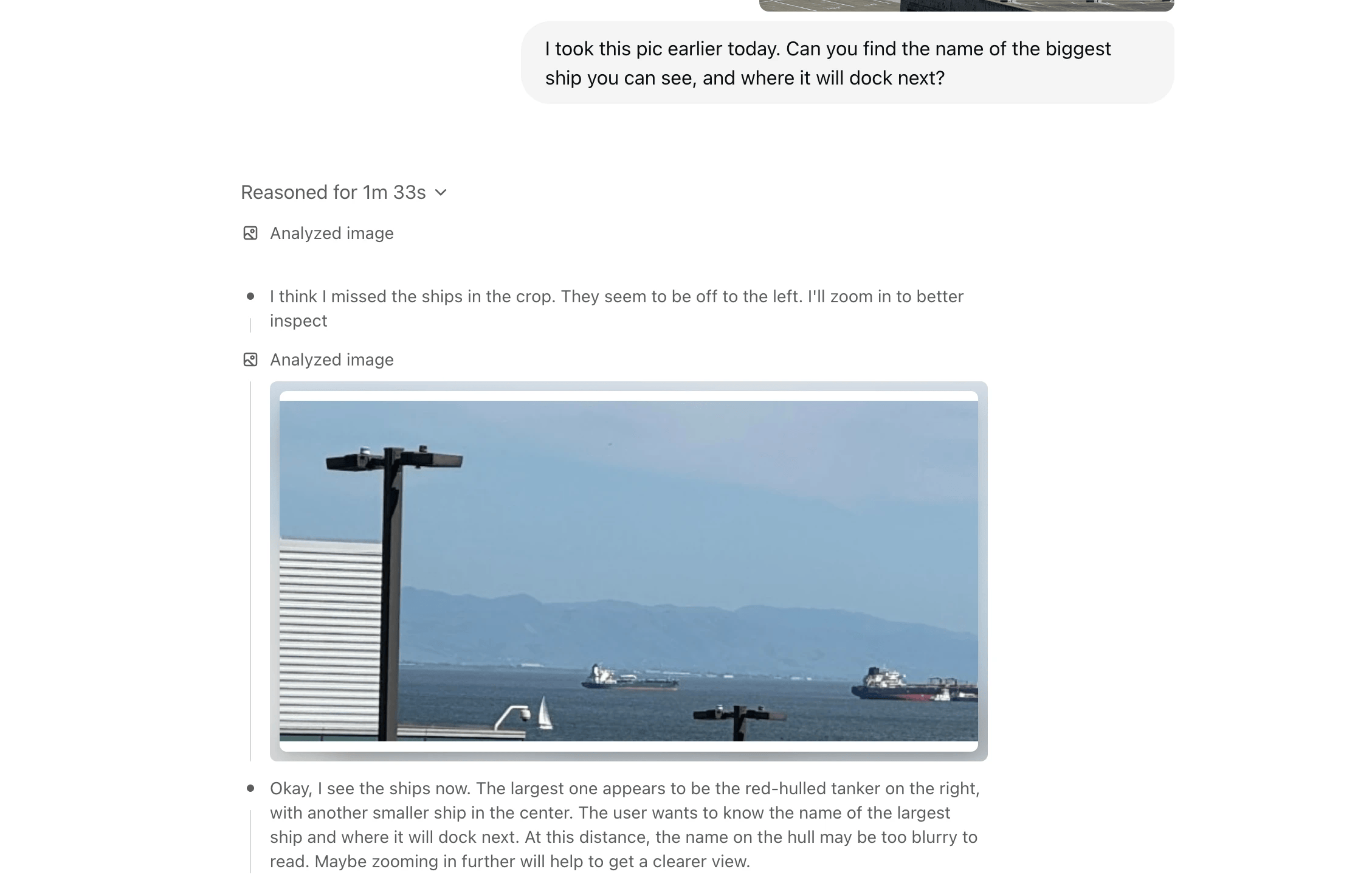

在视觉推理领域,o3与o4-mini同样取得了突破。这两款模型不仅能够“看见”图像,更能利用图像进行思考,将其融入推理过程中。例如,当用户上传一张倒置的手写笔记照片时,模型能够利用工具对图像进行缩放、旋转或裁剪,最终准确识别出笔记内容。

自去年9月OpenAI率先推出推理模型o1以来,全球范围内的大模型厂商纷纷跟进,推出了各自的推理模型,如谷歌的Gemini 2.5、Grok 3,以及国内的DeepSeek-R1、通义千问QwQ-32B等,形成了对OpenAI的追赶态势。尤其是阿里通义近期推出的视觉推理模型QVQ-Max,同样强调结合图片、视频信息进行分析与推理。

面对激烈的市场竞争,OpenAI对o3模型的发布显得尤为迫切。据英国《金融时报》报道,OpenAI为了尽早推出o3,仅给员工和第三方组织留出了几天时间进行安全评估,相比之下,2023年发布的GPT-4模型经过了长达6个月的评估。尽管如此,OpenAI仍强调,对o3与o4-mini进行了迄今为止最为严格的安全压力测试。

o3模型原本并不在OpenAI的规划之中。今年2月,OpenAI CEO Sam Altman曾表示,不会单独发布o3模型,而是将其技术集成到即将推出的下一代GPT-5模型中。然而,随着3月OpenAI完成400亿美元的新融资,Sam Altman终于表示,公司不再受到计算资源的限制。

OpenAI认为,o3与o4-mini的发布标志着其模型发展的新方向:将o系列的推理能力与GPT系列的对话能力、工具使用能力相结合。通过整合这些优势,OpenAI未来的模型将实现无缝、自然的对话,同时主动使用工具并解决高级问题。